Jak nie oddać danych sztucznej inteligencji?

Wszechobecne czaty i narzędzia oparte na dużych modelach językowych, jak chatGPT, Gemini czy Copilot pomagają nam w codziennych zadaniach zarówno w pracy jak i w domu. Czasami kusi, żeby nie zapoznawać się z dokumentem służbowym, danymi sprzedażowymi czy nawet podrzucić naszemu wirtualnemu asystentowi wyniki medyczne, żeby szybko i bezboleśnie wykonał analizę za nas. Ale czy to na pewno dobry pomysł?

Co się dzieje z moimi zapytaniami?

Zapytania, które kierujemy do algorytmów sztucznej inteligencji nie są przetwarzane na naszych telefonach czy komputerach, ale trafiają przez sieć do potężnych serwerów, które najczęściej nie znajdują się nawet w Unii Europejskiej – największe modele obsługiwane są w USA i Chinach. Domyślnie, szczególnie w przypadku darmowych licencji, dane te mogą być wykorzystywane do „trenowania” modeli, czyli będą dalej przetwarzane, w sposób często niejasny nawet dla samych twórców, z racji na ogrom skali. Właśnie dlatego narzędzia te, przynajmniej na razie, oferują darmowe modele – użytkownicy stanowią źródło informacji i są darmowymi testerami. Może się to skończyć tym, że numer telefonu, który nieopatrznie podaliśmy wypłynie jako odpowiedź rok później w Bangladeszu (co zdarzyło się już w choćby przypadku wklejenia do zapytania poufnych fragmentów kodu).

Dane jako paliwo

Chrapka na olbrzymie ilości danych, które umożliwiły działanie modelom jakie znamy dziś, skłania korporacje do nieetycznych działań. OpenAI, twórcy chataGPT zostali zasypani pozwami, po tym jak wyszło na jaw, że korzystali z treści do których nie mieli w teorii praw – np. artykułów New York Timesa czy całych książek. Po fali krytyki firma wprowadziła opcje wycofania swoich treści z danych treningowych i zawarła szereg płatnych umów na korzystanie z treści, natomiast pełna lista źródeł dalej pozostaje niejawna (dla innych modeli zresztą też). Wiele usługodawców, takich jak Meta (od Facebooka) czy Alphabet (od Google) łączy też swoje produkty, oferując dedykowane reklamy na bazie naszych konwersacji ze sztuczną inteligencją. Dokładnie tak, to stąd te dziwne reklamy.

Ale nikt tego nie czyta prawda? Prawda?

Czasem czyta. W regulaminie Gemini przeczytać możemy:

„Ludzcy recenzenci (w tym przeszkoleni recenzenci naszych dostawców usług) przeglądają niektóre z zebranych przez nas danych w tych celach. Nie wprowadzaj poufnych informacji, których nie chciałbyś, aby recenzent zobaczył lub aby Google wykorzystało je do ulepszania naszych usług, w tym technologii uczenia maszynowego.”

Podobne zapisy ma większość konkurencyjnych usług. Nasze dane mogą więc nie tylko przetwarzane automatycznie, ale również stanowić ciekawą lekturą dla specjalistów od ulepszania modeli. Polityki prywatności usług opartych o sztuczną inteligencję są długie i zawiłe, często też niejednoznaczne, gdyż legislacja w tym zakresie nie jest jeszcze dobrze dopracowana. Teoretycznie muszą one spełniać RODO, w praktyce wiele wskazuje na to, że to po prostu niemożliwe – bo przetworzonych danych nie da się już przypisać do konkretnego użytkownika.

Czym się nie dzielić

W skrócie – niczym, co nie chcielibyśmy, żeby trafiło na publiczne media społecznościowe. W szczególności nie wklejamy do zapytań:

- Prywatnych danych poufnych (PESEL, numer telefonu, email)

- Danych płatnicznych, kart kredytowych, wyciągów

- Dokumentów, w tym służbowych i medycznych

- Zdjęć prywatnych

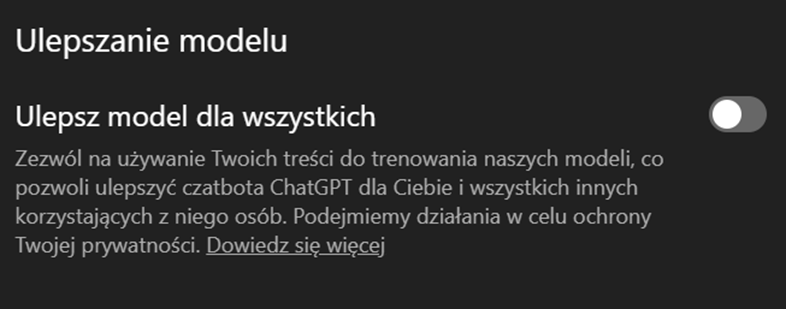

Korzystając z licencji darmowych i prywatnych warto zapoznać się z dodatkowymi ustawieniami prywatności danego modelu. Na przykład w opcjach chataGPT znajdziemy „ulepsz model dla wszystkich” – warto te pozycje odznaczyć. Komercyjne licencje narzędzi opartych o sztuczną inteligencję dają nam dodatkowe gwarancje, więc zdecydowanie warto się nimi zainteresować, gdy wykorzystujemy je w pracy.